„Menschen lernen nicht schwimmen, indem sie lesen“ – KI in der Mobilität wird physisch: von der Sprache zum Bild

Drei große Entwickler autonomer Fahrsysteme präsentieren Modelle, die auf Video-Training basieren

Published on Jan. 09, 2026

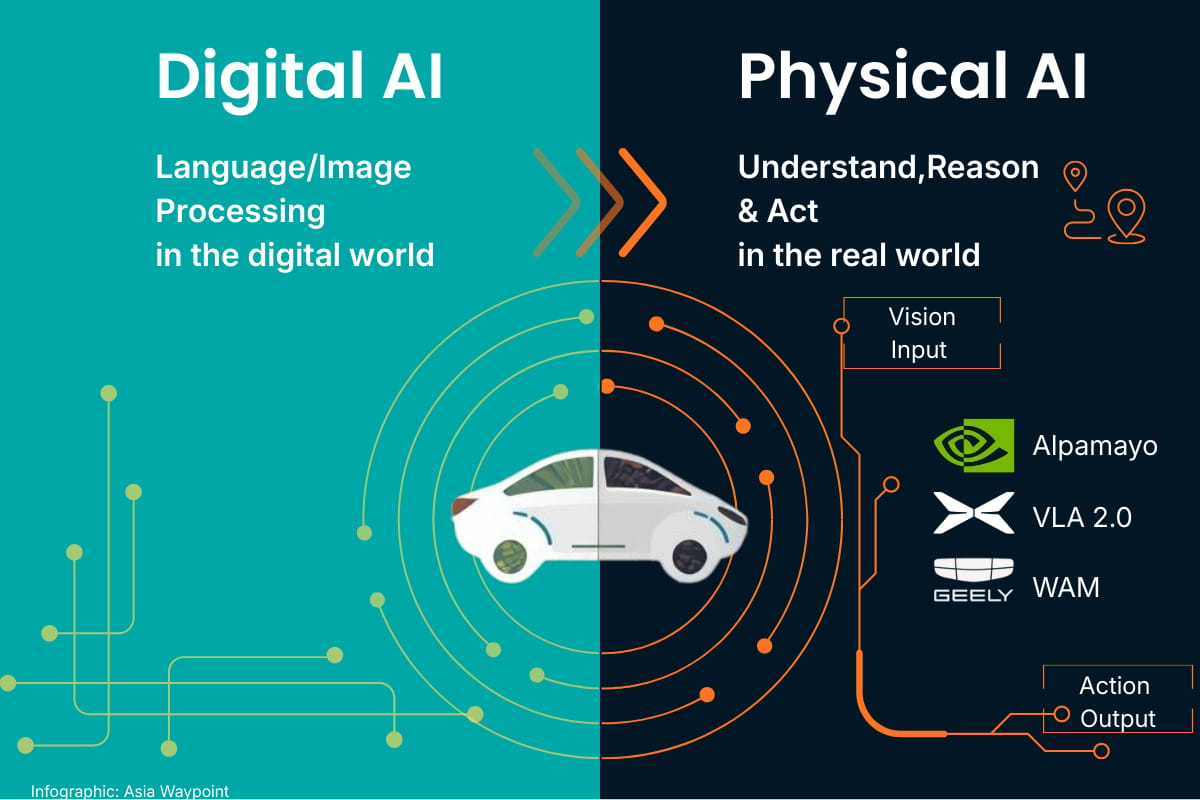

Für das autonome Fahren hat das neue Jahr mit einen Paukenschlag begonnen. Es zeichnet sich ein Paradigmenwechsel „von der Sprache zur Aktion“ ab. Mehrere große Player der Industrie in China und den USA setzen für ihre Fahrassistenz jetzt auf völlig neue Technologie‑Stacks, die auf World Models beruhen. Das sind Systeme, die eher visuell lernen als über die Sprache.

Das chinesische Elektro‑Start-up Xpeng erklärte, sein neues Großmodell VLA 2.0 sei mit rund 100 Millionen Videoclips trainiert worden – entsprechend der Zahl „extremer Fahrszenarien, die ein menschlicher Fahrer in 65.000 Jahren erleben würde“.

Laut Gründer und CEO He Xiaopeng markiert das „einen neuen Aufbruch für das autonome Fahren in China und den USA“, zitierte ihn das chinesische Fachportal Gasgoo vom globalen Produkt-Launch für das neue Modell in Guangzhou am 8. Januar 2026 (auf Chinesisch).

VLA 2.0 verfügt über 72 Milliarden Parameter und „versteht die physische Welt auf menschenähnliche Weise“, sagt Xpeng. Durch die Abschaffung des sprachbasierten Übersetzungsschritts ermögliche das System eine direkte Umsetzung visueller Wahrnehmung in Aktionen.

Sprache dient nicht mehr als Werkzeug für das Training des KI-Modells, sondern nur noch für zusätzliche Anweisungen. He Xiaopeng spricht von einer „grundlegenden Wende, weg vom Zeitalter der digitalen Intelligenz, hin zu einem neuen Paradigma, in dem KI die physische Welt direkt gestaltet“.

Während Xpeng mit seinem neuen, vorwiegend videobasiertem Training experimentierte, bemerkten die Ingenieure Anzeichen von „Emergence“. Das ist der Punkt, an dem eine KI beginnt, selbstständig zu lernen. So begannen die Testfahrzeuge plötzlich zu „kriechen“, während sei auf Kreuzungen zurollten, ohne dass dies programmiert worden war. Xpeng bezeichnet das als „Black‑Hole‑Effekt“. Ein weiteres Beispiel ist der „Ameisen-Kolonie-Effekt“, bei dem lokal kommunizierende Agenten eine erstaunliche kollektive Intelligenz ganz ohne zentrale Steuerung zeigten.

Xpeng gab an, Volkswagen als Startpartner gewonnen zu haben. Erste Straßentests mit Robotaxis, die mit VLA 2.0 ausgestattet sind, sollen bald beginnen. Drei Fahrzeuge sollen laut Unternehmen noch in diesem Jahr in Betrieb gehen. Auch erste PKW mit dem neuen KI-Modell sollen schon bald getestet werden.

Der ChatGPT‑Moment der physischen KI ist da.

Der Gründer und CEO von Nvidia, Jensen Huang, kündigte am 5. Januar 2026 auf der CES den Einstieg seines Unternehmens in das Geschäft mit dem autonomen Fahrens an. Dabei enthüllte er, dass Nvidia eine ähnliche technologische Route gewählt hat wie Xpeng.

„Der ChatGPT‑Moment der physischen KI ist gekommen; wenn Maschinen beginnen, die reale Welt zu verstehen, zu schlussfolgern und in ihr zu handeln“, sagte Jensen Huang, Gründer und CEO von Nvidia, laut einer.

Alpamayo sei „end‑to‑end“ trainiert worden, „buchstäblich von der Kamera bis zur Aktion“. Die Software soll zuerst im neuen Mercedes‑Benz CLA zum Einsatz kommen.

Auch Geely, Chinas zweitgrößter Autohersteller, nutzte die große Bühne der CES, um seine jüngsten Entwicklungen im Bereich „AI + Mobility“ vorzustellen. Geely präsentierte sein ganzheitliches World Action Model (WAM), das Fahrzeugen „eine evolvierende Weltsicht und Urteilsfähigkeit“ ermöglich soll.

WAM kombiniert ein multimodales Large‑Language‑Model (MLLM) mit einem World Model für prädiktive Simulationen, die „physikalische Handlungssequenzen innerhalb von Millisekunden“ nachbilden. Geelys System G‑ASD (Geely Afari Smart Driving) wird als Lösung beschrieben, die zur „End‑to‑End‑Selbstkorrektur“ befähigt. Das Fahrzeug „versteht, urteilt und sich entwickelt sich weiter“.

Gemeinsam deuten die neuen Ankündigungen von Xpeng, Nvidia und Geely daraufhin, dass sich das autonome Fahren ab diesem Jahr schneller in Richtung Level-4-Autonomie bewegen könnte als es bis jetzt möglich erschien. Mit der Entfernung der Sprachebene aus dem Training lernen die Systeme erheblich schneller, sagen die Hersteller.

Damit vollzieht sich in der Autoindustrie ein grundlegender Abschied von großen Sprachmodellen als dem heiligen Gral der KI. „Menschen lernen nicht schwimmen, indem sie lesen. Wir lernen durch unsere Sinne,“ sagt He Xiaopeng bei der Vorstellung seines neuen Modells.

Das validiert eine Position, die Fei‑Fei Li, Professorin für künstliche Intelligenz an der Stanford University, seit Langem vertritt. Sie plädiert für eine visuelle statt sprachzentrierte Entwicklung künstlicher Intelligenz.

„Komplexe Sprache ist einzigartig menschlich und hat sich in weniger als 500.000 Jahren entwickelt,“ sagt Li. „Doch das biologische Verständnis, die Interaktion und Kommunikation in der dreidimensionalen Welt haben sich über 540 Millionen Jahre evolutionär herausgebildet.“ KI bleibe unvollständig, solange das grundlegende Problem der räumlichen Intelligenz nicht gelöst sei, denkt sie.

Seit Beginn dieses Jahres sind einige der wichtigsten Akteure der Automobilindustrie in China und den Vereinigten Staaten ebenfalls dieser Meinung.